线性回归 梯度下降原理与基于Python的底层代码实现

线性回归基础知识可查看该专栏中其他文章。

文章目录

- 1 梯度下降算法原理

- 2 一元函数梯度下降示例代码

- 3 多元函数梯度下降示例代码

1 梯度下降算法原理

梯度下降是一种常用的优化算法,可以用来求解许包括线性回归在内的许多机器学习中的问题。前面讲解了直接使用公式求解θ\thetaθ (最小二乘法的求解推导与基于Python的底层代码实现),但是对于复杂的函数来说,可能较难求出对应的公式,因此需要使用梯度下降。

假设我们要求解的线性回归公式是:

y=β0+β1x1+β2x2+...+βnxn+ϵy = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_nx_n + \epsilony=β0+β1x1+β2x2+...+βnxn+ϵ

其中 yyy 是因变量,βi\beta_iβi 是回归系数,xix_ixi 是自变量,ϵ\epsilonϵ 是误差项。我们的目标是找到一组回归系数 βi\beta_iβi,使得模型能够最小化误差。

使用梯度下降算法求解线性回归可以分为以下步骤:

-

随机初始化回归系数 βi\beta_iβi。

-

计算模型的预测值 y^\hat{y}y^:

y^=β0+β1x1+β2x2+...+βnxn\hat{y} = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_nx_ny^=β0+β1x1+β2x2+...+βnxn

- 计算误差(或损失函数):

J(β0,β1,...,βn)=12m∑i=1m(yi−yi^)2J(\beta_0, \beta_1, ..., \beta_n) = \frac{1}{2m}\sum_{i=1}^{m}(y_i - \hat{y_i})^2J(β0,β1,...,βn)=2m1i=1∑m(yi−yi^)2

其中 mmm 是样本数量,yiy_iyi 是第 iii 个样本的真实值,yi^\hat{y_i}yi^ 是对应的预测值。

- 计算误差对于每个回归系数的偏导数:

∂J∂βj=1m∑i=1m(yi^−yi)xij\frac{\partial J}{\partial \beta_j} = \frac{1}{m}\sum_{i=1}^{m}(\hat{y_i} - y_i)x_{ij}∂βj∂J=m1i=1∑m(yi^−yi)xij

其中 xijx_{ij}xij 是第 iii 个样本的第 jjj 个特征值。

- 使用梯度下降更新回归系数:

βj=βj−α∂J∂βj\beta_j = \beta_j - \alpha\frac{\partial J}{\partial \beta_j}βj=βj−α∂βj∂J

其中 α\alphaα 是学习率,用来控制更新的步长。

- 重复步骤 2-5多次,直到误差达到某个预定的阈值或者达到预设的迭代次数。

梯度下降算法会不断迭代,直到误差最小化。通过不断更新回归系数,模型逐渐拟合数据,从而得到最终的结果。

(非常经典的图,已经要盘包浆了)

2 一元函数梯度下降示例代码

- 导入此次代码所需的包,设置绘图时正常处理中文字符。

import numpy as np

import matplotlib as mpl

import matplotlib.pyplot as plt mpl.rcParams['font.sans-serif'] = [u'SimHei']

mpl.rcParams['axes.unicode_minus'] = False

- 定义本次要模拟的函数。为了方便起见,这里直接对函数的导数进行了定义。也可根据需要调包求梯度或者自己写一个求偏导的类。

# 一维原始图像

def f1(x): return 0.5 * (x - 2) ** 2

# 导函数

def h1(x): return 0.5 * 2 * (x - 2)

- 初始化梯度下降中的参数

GD_X = []

GD_Y = []

x = 4

alpha = 0.1

f_change = 1

f_current = f1(x)

GD_X.append(x)

GD_Y.append(f_current)

iter_num = 0

此处GD_X与GD_Y两个列表分别用于存储梯度下降的每一步取值,用于后面的画图。x是梯度下降的起点,可设置为随机数。f_change用于存储执行每次循环之后,y的变化值。此处赋值的意义仅在于确保能进入下面的循环而不会报错。iter_num用于记录循环执行的次数。alpha学习率,取值过大容易难以收敛,取值过小容易增加计算量。

4. 梯度下降步骤的循环

while f_change > 1e-10 and iter_num < 1000:iter_num += 1 x = x - alpha * h1(x) tmp = f1(x) f_change = np.abs(f_current - tmp) f_current = tmp GD_X.append(x) GD_Y.append(f_current)

循环结束的标准为:两次循环的y值变化(即f_change)小于1e-10或循环次数大于100。

每次循环,x的变化量都是学习率乘以这一点的梯度。之后计算变化后x对应的y和变化前x对应的外,获得两次y的差值。并将每次运行的结果使用append保存到列表之中。

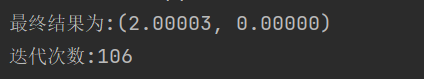

5. 结果输出

print(u"最终结果为:(%.5f, %.5f)" % (x, f_current))

print(u"迭代次数:%d" % iter_num)

大概100次后,我们找到了损失函数最小值所对应的x。

6. 结果绘图

X = np.arange(-2, 6, 0.05)

Y = np.array(list(map(lambda t: f1(t), X))) plt.figure(facecolor='w')

plt.plot(X, Y, 'r-', linewidth=2)

plt.plot(GD_X, GD_Y, 'bo--', linewidth=2)

plt.title(f'函数$y=0.5 * (θ - 2)^2$ \n学习率:{alpha:.3f} 最终解:x={x:.3f} y={f_current:.3f} 迭代次数:{iter_num}')

plt.show()

可以自行尝试不同的起点,不同的学习速率对结果的影响。

3 多元函数梯度下降示例代码

当变量数为2时,梯度下降可以使用3维绘图展示。当变量书超过2时,损失函数变为超平面难以展示,因此此处以二元函数为例。

- 定义本次要模拟的函数。

# 二元函数定义

def f2(x, y): return (x - 2) ** 2 + 2* (y + 1) ** 2

# 偏导数

def hx2(x, y): return 2*(x - 2)

def hy2(x, y): return 4*(y + 1)

与一元函数相同,我们对函数的偏导数直接定义,减少非本博客相关的代码。

2. 初始化梯度下降中的参数

GD_X1 = []

GD_X2 = []

GD_Y = []

x1 = 4

x2 = 4

alpha = 0.01

f_change = 1

f_current = f2(x1, x2)

GD_X1.append(x1)

GD_X2.append(x2)

GD_Y.append(f_current)

iter_num = 0

这里与一元函数的参数基本相同,只是多了一个用于存储额外维度的listGD_X2。

3. 梯度下降步骤的循环

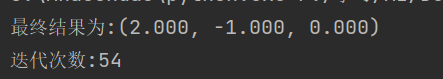

while f_change > 1e-10 and iter_num < 1000: iter_num += 1 prex1 = x1 prex2 = x2 x1 = x1 - alpha * hx2(prex1, prex2) x2 = x2 - alpha * hy2(prex1, prex2) tmp = f2(x1, x2) f_change = np.abs(f_current - tmp) f_current = tmp GD_X1.append(x1) GD_X2.append(x2) GD_Y.append(f_current) print(u"最终结果为:(%.3f, %.3f, %.3f)" % (x1, x2, f_current))

print(u"迭代次数:%d" % iter_num)

此处的逻辑与一元函数基本相同。对于每一个x,都使用对应的偏导数乘以学习速率,从而获得新的x值。如果是二元以上的多元函数同理。

运行结果为:

- 绘图

X1 = np.arange(-5, 5, 0.2)

X2 = np.arange(-5, 5, 0.2)

X1, X2 = np.meshgrid(X1, X2)

Y = np.array(list(map(lambda t: f2(t[0], t[1]), zip(X1.flatten(), X2.flatten()))))

Y.shape = X1.shapefig = plt.figure(facecolor='w')

ax = Axes3D(fig)

ax.plot_surface(X1, X2, Y, rstride=1, cstride=1, cmap=plt.cm.jet, alpha=0.8)

ax.plot(GD_X1, GD_X2, GD_Y, 'ko-')

ax.set_xlabel('x')

ax.set_ylabel('y')

ax.set_zlabel('z')

plt.show()

对于三维数据,我们使用meshgrid构建了绘图网格,用于绘制函数图像。在绘制完函数图像的基础上,绘制梯度下降每一步的图像。绘制折线图时,ko-代表黑色、圆点、虚线。

(3D图像建议设置为单独显示,方便拖动视角查看)

实际上,梯度下降的种类也有很多,比如随机梯度下降、批量梯度下降,小批量梯度下降。这些内容将会在下一篇博客中进行讲解。