yolov5 网络结构(暂记)

Backbone :Focus + BottleneckCSP+SPP

Focus

- Focus模块在v5中是图片进入backbone前,对图片进行切片操作,具体操作是在一张图片中每隔一个像素拿到一个值,类似于邻近下采样,这样就拿到了四张图片,四张图片互补,长的差不多,但是没有信息丢失,这样一来,将W、H信息就集中到了通道空间,输入通道扩充了4倍,即拼接起来的图片相对于原先的RGB三通道模式变成了12个通道,最后将得到的新图片再经过卷积操作,最终得到了没有信息丢失情况下的二倍下采样特征图。

CSP/C3

SPP

class SPP(nn.Module):def __init__(self):super().__init__()self.maxpool1 = nn.MaxPool2d(kernel_size = 5, stride = 1, padding=2)self.maxpool2 = nn.MaxPool2d(9, 1, padding=4)self.maxpool3 = nn.MaxPool2d(13, 1, padding=6)def forward(self, x):o1 = self.maxpool1(x)o2 = self.maxpool2(x)o3 = self.maxpool3(x)return torch.cat([x, o1, o2, o3], dim=1)

空间金字塔池化层(SPP Layer),其优势在于不用固定图像输入的尺寸即可产生相同大小的输出特征,同时融合了多尺度池化信息。

从SPP改进为SPPF后,模型的计算量变小了很多

class SPPF(nn.Module):# Spatial Pyramid Pooling - Fast (SPPF) layer for YOLOv5 by Glenn Jocherdef __init__(self, c1, c2, k=5): # equivalent to SPP(k=(5, 9, 13))super().__init__()c_ = c1 // 2 # hidden channelsself.cv1 = Conv(c1, c_, 1, 1)self.cv2 = Conv(c_ * 4, c2, 1, 1)self.m = nn.MaxPool2d(kernel_size=k, stride=1, padding=k // 2)def forward(self, x):x = self.cv1(x)with warnings.catch_warnings():warnings.simplefilter('ignore') # suppress torch 1.9.0 max_pool2d() warningy1 = self.m(x)y2 = self.m(y1)return self.cv2(torch.cat((x, y1, y2, self.m(y2)), 1))

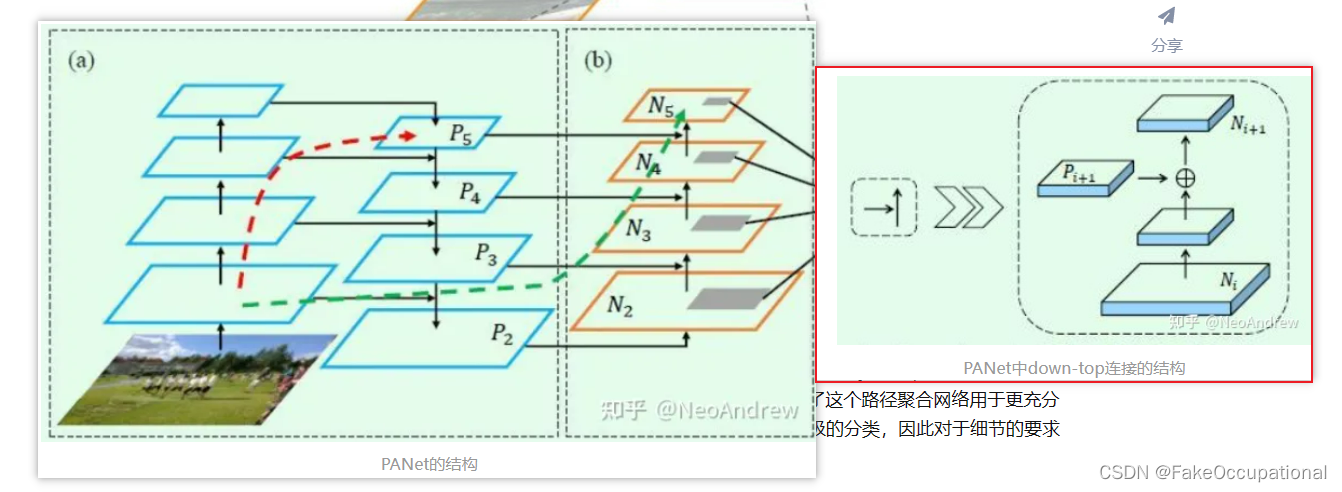

PANet PANet是一个加强版的FPN

和Yolov3的FPN层不同,Yolov4在FPN层的后面还添加了一个自底向上的特征金字塔。这样结合操作,FPN层自顶向下传达强语义特征,而特征金字塔则自底向上传达强定位特征,两两联手,从不同的主干层对不同的检测层进行参数聚合,这样的操作确实很皮。

-

FPN:最顶层的特征会经过x2的上采样插值后和底层feature map相加

-

目标检测的FPN和Unet有差别吗? FPN的“放大”部分是直接插值放大的,没有deconvolution的filters学习参数;U-Net“放大”部分就是Decoder,需要deconvolution的filters学习参数的。FPN对每一个融合的层都做detection;U-Net 只在最后一层做segmentation的pixel预测

-

PAN后段结构

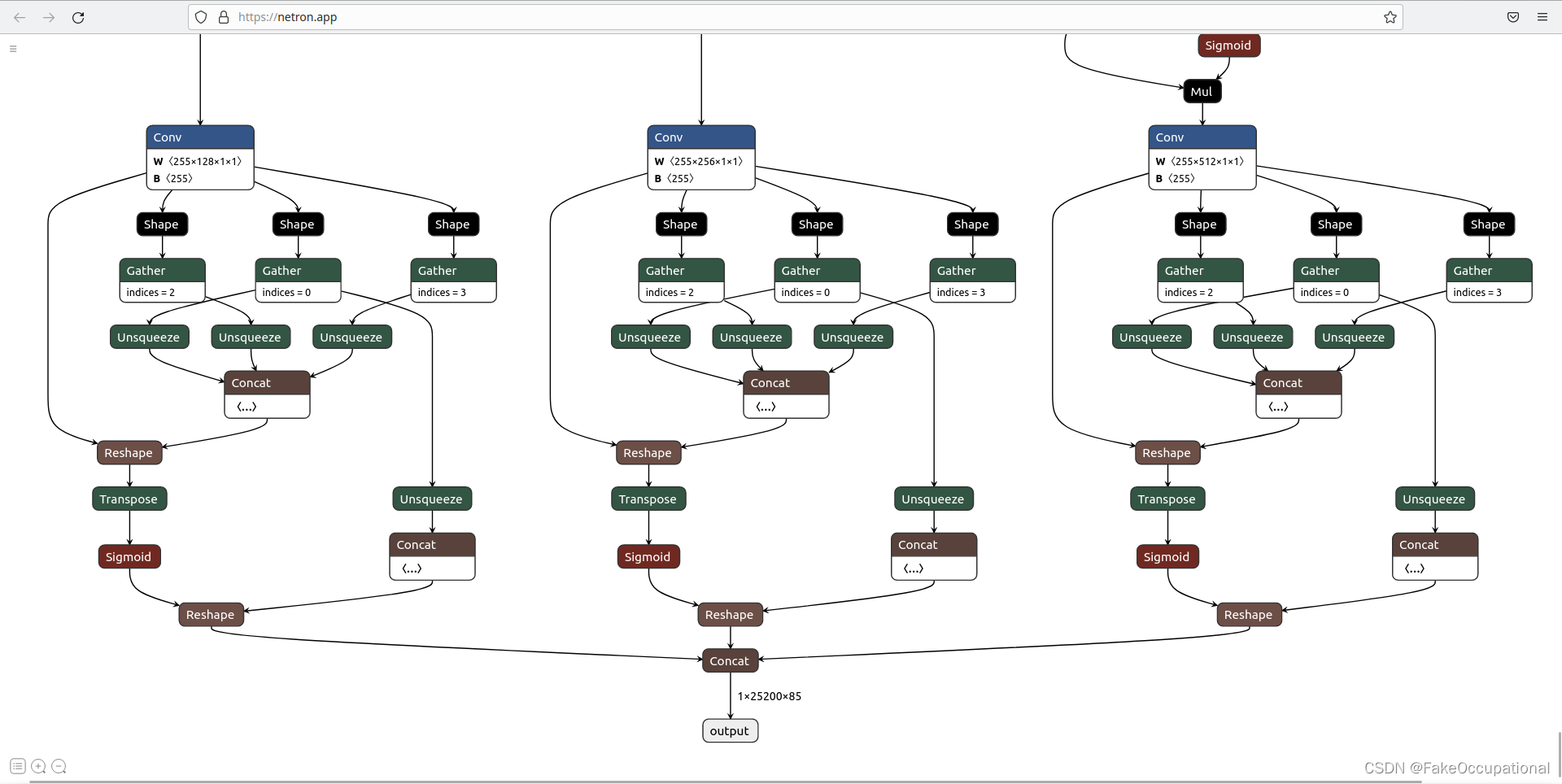

HEAD

OUT

- 输出80 * 80*255(40 * 40*255,20 * 20*255)

边界框匹配与损失

1 将归一化中心点位置、宽高映射到640。

2 计算中心点在80 * 80的位置,

3 分别计算3个anchor与映射后gt宽高的宽和高的比,宽高比满足条件时才计算矩形框损失(将3*80*80对应值设置为true,false不加入到loss)

4 矩形框损失计算 L1、L2、smooth L1损失函数

IOU损失

这种计算方法的前提假设是中心点x坐标、中心点y坐标、宽、高这四个值是相互独立的,实际上它们具有相关性,所以该计算方法存在问题。

置信度损失计算原理

yolo之前版本直接对mask矩阵为true的地方赋值1,mask矩阵为false的地方赋值0。yolov5版本mask为true的位置不直接赋1,而是计算对应预测框与目标框的CIOU,需要对CIOU做一个截断处理:当CIOU小于0时直接取0值作为标签。

9个ancher的使用:

宽、高最小的anchor0、anchor1、anchor2分配给80 * 80网格的每个格子;

宽、高次小的anchor3、anchor4、anchor5分配给40 * 40网格的每个格子;

宽、高最大的anchor6、anchor7、anchor8分配给20 * 20网格的每个格子。

yaml

# parameters

nc: 3 # number of classes

depth_multiple: 0.67 # model depth multiple 控制模型大小:将乘上backbone的umbers再取整

width_multiple: 0.75 # layer channel multiple 控制模型大小:控制输出# anchors

anchors:- [10,13, 16,30, 33,23] # P3/8 在最大的特征图上的锚框 一般希望在大的特征图上去检测小目标,因为大特征图才含有更多小目标信息 https://blog.csdn.net/qq_27278957/article/details/120036450- [30,61, 62,45, 59,119] # P4/16 在中间的特征图上的锚框- [116,90, 156,198, 373,326] # P5/32 在最小的特征图上的锚框# YOLOv5 backbone

backbone:# [from, number, module, args][[-1, 1, Focus, [64, 3]], # 0-P1/2 from=-1 表示当前层的输入由上一阶段获取 [64, 3] 中64表示输出channels(需要*width_multiple)[-1, 1, Conv, [128, 3, 2]], # 1-P2/4 [128, 3, 2] 中 3, 2对应 卷积大小 padding[-1, 3, BottleneckCSP, [128]], # 0-P1 第一行 Focus(下采样)的结构 https://blog.csdn.net/weixin_55073640/article/details/122539858, 详见commom.py[-1, 1, Conv, [256, 3, 2]], # 3-P3/8[-1, 9, BottleneckCSP, [256]],[-1, 1, Conv, [512, 3, 2]], # 5-P4/16[-1, 9, BottleneckCSP, [512]],[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32[-1, 1, SPP, [1024, [5, 9, 13]]],[-1, 3, BottleneckCSP, [1024, False]], # 9]# YOLOv5 head

head:[[-1, 1, Conv, [512, 1, 1]],[-1, 1, nn.Upsample, [None, 2, 'nearest']],[[-1, 6], 1, Concat, [1]], # cat backbone P4[-1, 3, BottleneckCSP, [512, False]], # 13[-1, 1, Conv, [256, 1, 1]],[-1, 1, nn.Upsample, [None, 2, 'nearest']],[[-1, 4], 1, Concat, [1]], # cat backbone P3[-1, 3, BottleneckCSP, [256, False]], # 17[-1, 1, Conv, [256, 3, 2]],[[-1, 14], 1, Concat, [1]], # cat head P4[-1, 3, BottleneckCSP, [512, False]], # 20[-1, 1, Conv, [512, 3, 2]],[[-1, 10], 1, Concat, [1]], # cat head P5[-1, 3, BottleneckCSP, [1024, False]], # 23# 以上的部分可称为booleneck[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5) 17, 20, 23 表示层的标号]

CG

-

yolov5 的 detect 层 与 anchor 机制 - - https://blog.csdn.net/weixin_44956310/article/details/121745474

-

https://zhuanlan.zhihu.com/p/563598234

-

yolov5anchor的作用

-

https://zhuanlan.zhihu.com/p/540786844 DINO端到端可学习的目标监测,没有NMS

-

https://zhuanlan.zhihu.com/p/367069340从yolov1来理解yolov5

-

https://blog.csdn.net/weixin_43427721/article/details/123673383