深度学习(21)——关于训练过程中loss和acc固若磐石

创始人

2025-05-30 10:23:32

深度学习(21)——关于训练过程中loss和acc固若磐石

1. 背景描述

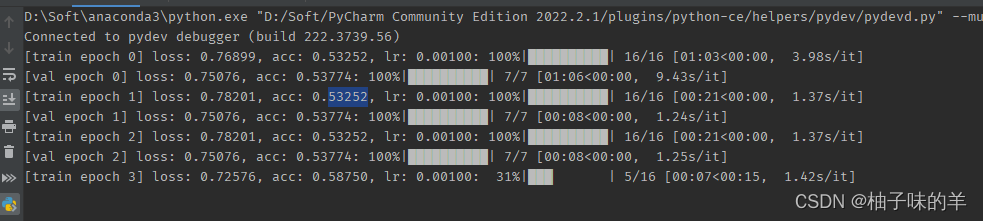

最近在做时间序列,思路清晰明朗,model全部搭建好了,但是loss和acc固若磐石,稳步不动。还是分类任务,因为是之前调试过的代码,后来自己手写了一遍(对自己非常有信心!)结果,就出现了这种情况。

2. 问题排查

听师兄的话,一定会找到bug的原因。我去掉时间序列,直接用自己手写的代码去做分类,竟然出现和上面同样的情况,OOTD,麻了。debug吧!在loss的地方跳了又跳,检查了又检查,都没查出错误,一天过去了。今天早上对着代码又检查,oh no,被自己蠢到了!

我的loss:预测的label和真实的label在做loss

_, output = model(images.to(device))

pred_class = torch.sigmoid(output).gt(0.5).int()

accu_num += torch.eq(pred_class.squeeze_(), labels.to(device)).sum() # 正确的个数

loss = loss_function(pred_class.float(), labels.to(device).float())

loss = loss_function(pred_class.float(), labels.to(device).float())扪心自问:这loss能这样写吗???这不是难为机器吗???机器内心独白:大人啊!只有0和1这些标签,让我学什么??这不是难为我吗??

3. 来吧!解决问题!

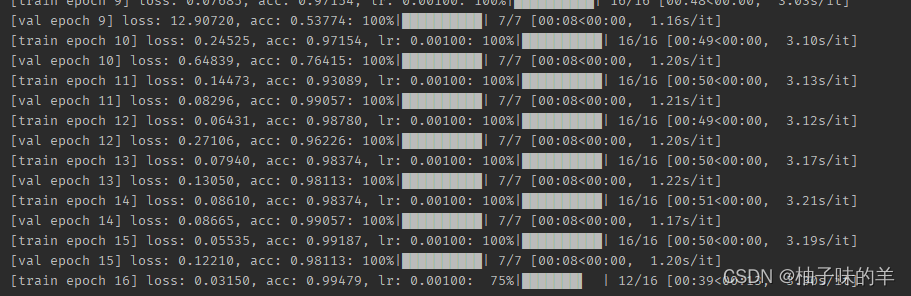

得到预测的分类结果(0,1,2,3,4…这种离散结果)只用于计算模型预测的准确个数,loss是需要让他反向传播去学习怎么变化的,所以应该是他和真实值之间的差异!正确的写法:

loss = loss_function(output.float(), labels.to(device).float())

886,只希望自己以后少出现这种低级错误!

相关内容

热门资讯

到中国过年!外国游客晒出春节新...

来源:央视新闻客户端上周,外交部发言人提到,今年,外国游客春节来华机票的预订量,同比增长超过了400...

原创 南...

南瓜,这个季节的宠儿,以其甘甜的口感和丰富的营养价值,成为了餐桌上的常客。然而,如何将这平凡的食材烹...

春节期间来天津吃啥?当地人推荐...

#年味里的中国# 天津的吃食,从来不是摆谱的玩意儿,是跟着漕运的船、码头的汗,一点点熬出来的。 早...

姑苏早餐必吃!鱼肉鸡汤云吞,皮...

春节的脚步渐近,姑苏的街巷开始弥漫着浓浓的年味。此时,早晨的早点铺已悄然迎来了一波食客,热气腾腾的美...

商圈年夜饭花样上新

春节临近,小店区餐饮市场热闹非凡。从传统堂食的一桌难求,到外卖礼盒的便捷精致,再到私厨上门的个性化服...